Veliki jezični modeli (Large Language Models odnosno LLM) su alati za umjetnu inteligenciju koji mogu čitati, sažeti i prevesti tekst te predvidjeti nadolazeće riječi u rečenici stvarajući rečenice koje su vrlo slične onima koje koriste pravi ljudi. Ti modeli trenirani su na velikim količinama podataka, što znači da model može naučiti nove sposobnosti koje nisu uvijek isplanirane.

Primjerice, dodavanje više „podataka namijenjenih za treniranje” jezičnom modelu može neočekivano rezultirati time da dobije sposobnost prevođenja između različitih jezika, iako za to nije bio obučen.

Nove sposobnosti tog tipa nazivaju se emergentne sposobnosti, tj. sposobnosti koje iskrsnu, a nisu nužno planirane. Kako se navodi u jednom istraživačkom radu: „Iako postoje deseci primjera emergentnih sposobnosti, trenutačno postoji malo uvjerljivih objašnjenja zašto se takve sposobnosti pojavljuju na način na koji se pojavljuju.“

Ni stručnjaci ne mogu objasniti zašto se različite sposobnosti uče, ali je dobro poznato da povećanje količine podataka za obuku/treniranje stroja omogućuje učenje više sposobnosti.

S druge strane, loša strana povećanja podataka namijenjenih za treniranje je ta što je potrebno više računalne snage za proizvodnju izlaznih podataka (outputa), što čini AI sporijim u trenutku kada generira tekstualni output – trenutak koji se naziva „vrijeme inferencije“.

Dakle, kompromis pri tome da umjetna inteligencija bude pametnija s više podataka jest da umjetna inteligencija također postaje sporija u vremenu inferencije.

Pouzdano prilagodljivo modeliranje jezika

Istraživači u Googleu došli su do zanimljivog rješenja za ubrzavanje jezičnih modela uz istovremeno održavanje visokih performansi.

Rješenje je, da napravimo analogiju, nešto poput razlike između odgovora na jednostavno pitanje i rješavanja težeg. Na lako pitanje, poput “Koje je boje nebo?”, može se odgovoriti bez puno razmišljanja. Međutim, težak odgovor zahtijeva da zastanete i još malo razmislite.

Računalno govoreći, veliki jezični modeli ne prave razliku između teškog i lakog dijela zadatka generiranja teksta. Oni generiraju tekst i za lakše i za teže dijelove koristeći svoju punu računalnu snagu u vremenu zaključivanja.

Googleovo rješenje zove se Confident Adaptive Language Modeling (CALM).

Ono što ovaj novi okvir čini boljim jest posvećivanje manje resursa trivijalnim dijelovima zadatka generiranja teksta i posvećivanje pune snage težim dijelovima.

Istraživački rad o CALM-u navodi problem i rješenje ovako:

Najnovija dostignuća u velikim jezičnim modelima (LLM) koji se temelje na transformiranju dovela su do značajnih poboljšanja performansi kroz mnoge zadatke.

Ti dobici dolaze s drastičnim povećanjem veličine modela, što potencijalno dovodi do spore i skupe uporabe u vremenu inferencije.

U praksi, međutim, niz generacija koje provedu LLM-ovi sastoje se od različitih stupnjeva težine.

Dok određena predviđanja doista imaju koristi od punog kapaciteta modela, drugi su nastavci trivijalniji i mogu se riješiti uz smanjenu računalnu snagu.

CALM radi tako da dinamički dodjeljuje resurse ovisno o složenosti pojedinog dijela zadatka, koristeći algoritam za predviđanje trebaju li za nešto puni ili djelomični resursi.

Istraživači objašnjavaju da su testirali novi sustav za različite zadatke obrade prirodnog jezika („sažimanje teksta, strojno prevođenje i odgovaranje na pitanja“) te otkrili da su uspjeli ubrzati inferenciju za čak 300 posto.

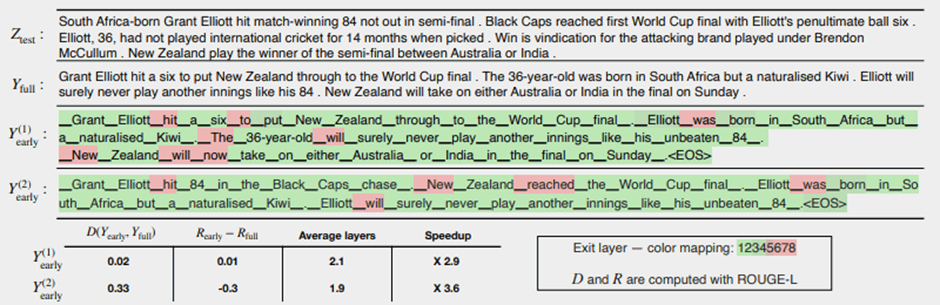

Slika 1 u nastavku pokazuje koliko dobro sustav CALM funkcionira. Nekoliko područja u crvenoj boji pokazuju gdje je stroj morao iskoristiti svoj puni kapacitet. Područja u zelenoj boji su mjesta na kojima je stroj koristio manje od pola kapaciteta.

Istraživači napominju da implementacija CALM-a zahtijeva tek minimalne izmjene kako bi se jedan veliki jezični model prilagodio da postane brži.

Ovo je istraživanje važno jer otvara vrata stvaranju složenijih modela umjetne inteligencije koji se obučavaju na znatno većim skupovima podataka bez da iskuse sporije brzine te uz zadržavanje visoke razine performansi.

Ipak, moguće je da ova metoda može poslužiti i za velike jezične modele koji su obučeni na temelju manje količine podataka. Na primjer, modeli InstructGPT, čiji je srodni model ChatGPT, treniraju se na približno 1,3 milijarde parametara pa još uvijek mogu nadmašiti modele koji se treniraju na znatno više parametara.

Istraživači su u zaključku istaknuli:

Općenito, naš kompletan prilagodljivi računalni okvir za LM-ove zahtijeva minimalne izmjene temeljnog modela i omogućuje povećanje učinkovitosti uz zadovoljavanje rigoroznih jamstva kvalitete za output.

Informacije o ovom istraživačkom radu objavljene su na Googleovom AI blogu 16. prosinca 2022. Sam istraživački rad nosi datum 25. listopada 2022.